Towards Unified Conversational Recommender Systems via Knowledge-Enhanced Prompt Learning

通过知识增强的提示学习实现统一的CRS KDD 2022

摘要

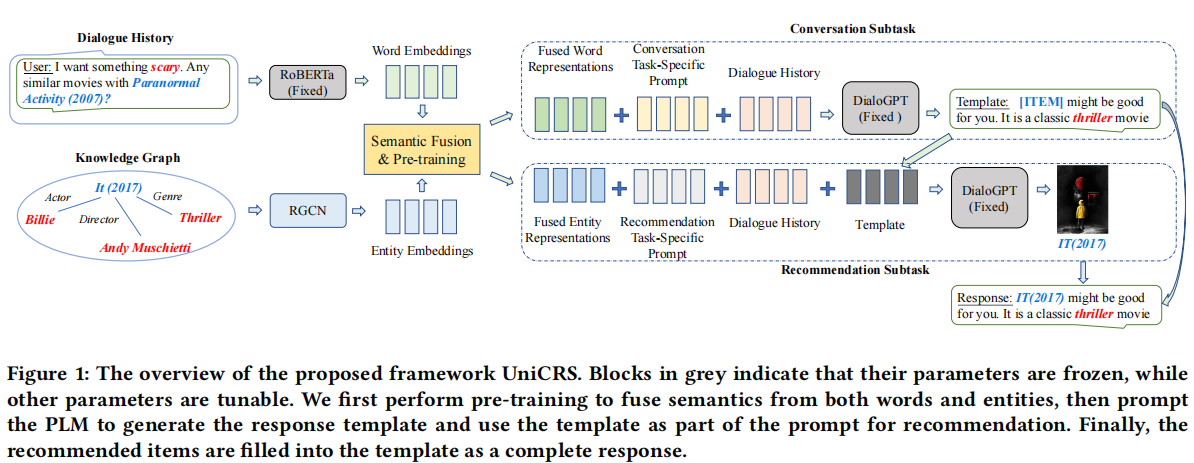

- propose a unified CRS model named UniCRS based on knowledge-enhanced prompt learning.

- unifies the recommendation and conversation subtasks into the prompt learning paradigm, and utilizes knowledge-enhanced prompts based on a fixed pre-trained language model (PLM) to fulfill both subtasks in a unified approach.

- In the prompt design, we include fused knowledge representations, task-specific soft tokens,and the dialogue context, which can provide sufficient contextual information to adapt the PLM for the CRS task.

- for the recommendation subtask, we also incorporate the generated response template as an important part of the prompt, to enhance the information interaction between the two subtasks.

动机

- Existing works either design semantic alignment strategies, or share knowledge resources and representations between the two modules. However, these approaches still rely on different architectures or techniques to develop the two modules, making it difficult for effective module integration.

现有的工作要么设计语义对齐策略,要么在两个模块之间共享知识资源和表示。然而,这些方法仍然依赖于不同的架构或技术来开发这两个模块,这使得有效的模块集成变得困难。 - it has been pointed out that the generated responses from the conversation module do not always match the predicted items from the recommendation module

方法

用于提示学习的语义融合

- 根据先前的研究,本文将 KG 合并为特定于任务的知识资源,因为它涉及对话中提到的实体和项目的有用知识。然而,已经发现对话的语义空间和 KGs 之间存在很大的语义差距。 本文需要首先融合两个语义空间以进行有效的知识对齐和丰富。 特别是,这一步的目的是融合来自不同编码器的令牌和实体嵌入。

- 编码词标记和知识图谱实体:给定对话历史 ,本文首先将对话历史中出现的对话词和 KG 实体分别编码为词嵌入和实体嵌入。 为了补充本文的基础 PLM DialoGPT(单向解码器),本文采用了另一个固定的 PLM RoBERTa(双向编码器)来推导词嵌入。

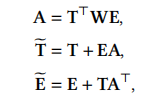

- 词实体语义融合:为了弥合词和实体之间的语义鸿沟,本文使用交叉交互机制通过双线性变换将两种语义表示联系起来:

- 预训练融合模块:为了更好地优化融合模块的参数,提出了一种基于提示的预训练方法,它利用了对话中的自我监督信号

特定于子任务的提示设计

- 虽然基础 PLM 是固定的,无需微调,但本文可以设计特定的提示以使其适应 CRS 的不同子任务。 对于每个子任务(推荐或对话),提示的主要设计由三部分组成,即对话历史、子任务特定软令牌和融合知识表示。 对于推荐,本文进一步将生成的响应模板合并为额外的提示标记。 接下来,本文详细描述这两个子任务的具体提示设计。

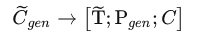

- 提示生成响应:响应生成的提示由原始对话历史记录(以单词标记 的形式)、特定于生成的软标记(以潜在向量 P 的形式)和融合的文本上下文(以潜在向量 T~ 的形式)组成。

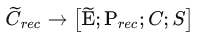

- 提示项目推荐:项目推荐提示由原始对话历史 (以单词标记的形式)、特定于推荐的软标记 P(以潜在向量的形式)、融合实体上下文 E~(以潜在向量的形式)和 响应模板 (以单词标记的形式)。

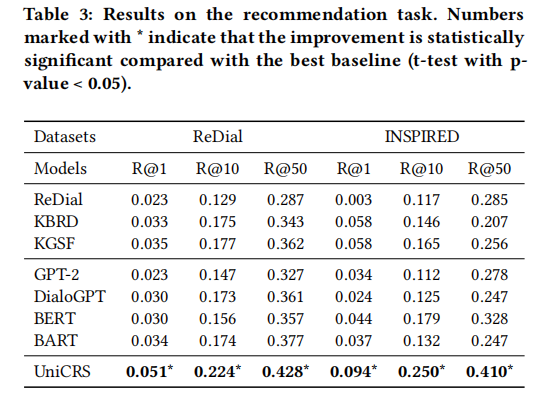

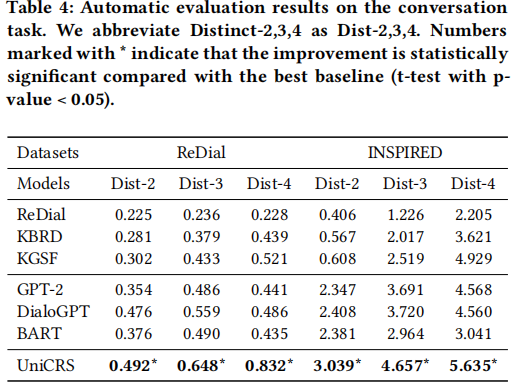

实验和结果

KGSF > KBRD > ReDial。 KGSF 和 KBRD 都将外部 KG 纳入其推荐模块中,这可以丰富对话历史中提到的实体的语义,以更好地捕捉用户意图和偏好。 此外,KGSF 还采用互信息最大化的方法来进一步改进实体表示。 对于四个预训练模型,本文可以看到 BERT 和 BART 的表现优于 GPT-2 和 DialoGPT。 原因可能是 GPT-2 和 DialoGPT 基于单向 Transformer 架构,这限制了它们的对话理解能力。 此外,可以看到 BART 在 ReDial 数据集上实现了相当的性能,甚至优于 BERT。 这表明 BART 也可以很好地理解推荐任务的对话语义。最后,可以看到本文模型大大优于所有基线。 本文利用专门设计的提示来指导基础 PLM,并结合 KG 通过预训练任务提高提示质量。

启发

Original link: http://example.com/2023/02/24/Knowledge-Enhanced-Prompt-Learning/

Copyright Notice: 转载请注明出处.