Evaluating the Robustness of Conversational Recommender Systems by Adversarial Examples

动机

- 测试CRS系统的鲁棒性,考虑到人机交互时输入信息的复杂性

贡献

- 提出了一种包含两类四种方案的对抗性评估方案,并自动生成对抗性实例来评估这些系统在面对不同输入数据时的鲁棒性。

- 对三个CRS模型进行了对抗测试,结果都是较差的鲁棒性

四种方案

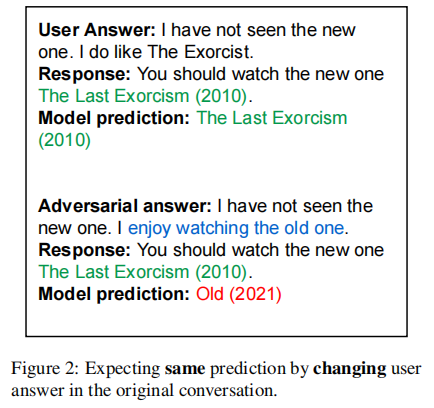

- expecting the same prediction by changing the user’s answer

期望得到相同的预测,但改变用户的回答

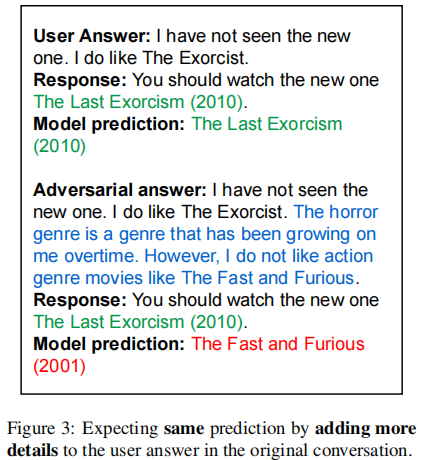

- expecting the same prediction by adding more details to the user’s answer

期望得到相同的预测,但为用户的回答中添加更多的信息

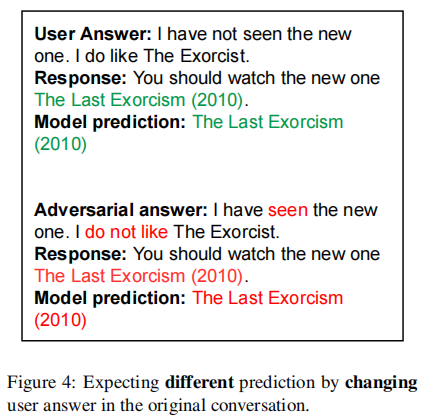

- expecting a different prediction by

changing the user’s answer

期望得到不同的预测,但改变用户的回答

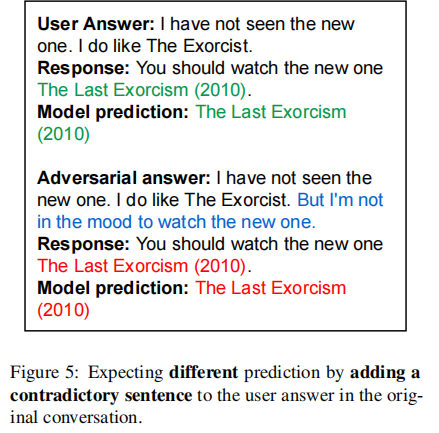

- expecting a different prediction by adding a contradictory sentence to the user’s answer

期望得到不同的预测,但为用户的回答中添加一句矛盾的句子

结果分析及启发

- We believe that if a model needs to be successful in this task, should have a strong attention mechanism on the user’s answer. This helps the system to fully understand user preferences.

- first needs to decide which words are important in the user’s answer, then consider all these important words (which are user preferences) in the recommendation.

这篇文章通过一些对抗实例来测试如今一些好的CRS模型,发现其鲁棒性较差的问题。大部分性能都是下降了,说明在复杂句子中去理解单词的重要性以充分理解用户偏好对CRS性能提升很重要。但也有略微上升的情况,是否可以说明增加适当的对抗或者说干扰,对模型的鲁棒性有一定的提升?

带来的思考在于,对抗与非对抗之间的平衡,一方面CRS模型要能抵御一些句子层面上的干扰,另一方面能将干扰化为己用来提高性能。

Original link: http://example.com/2023/03/20/CRS-Adversarial-Examples/

Copyright Notice: 转载请注明出处.